Pedofilia e IA: el riesgo de publicar fotos de niños en tiempos en que los robots todo lo pueden

Distintos organismos internacionales alertan sobre la utilización de inteligencia artificial (IA) para crear material de abuso sexual infantil (MASI) o -mal llamado- “pornografía infantil”. Los desafíos de actualizar el marco legal ante los deepfakes.

Un informe de la organización Internet Watch Foundation advirtió por primera vez sobre un nuevo y peligroso fenómeno relacionado con uno de los avances tecnológicos más importantes de los últimos años: mientras muchos debaten los alcances y los efectos que la tecnología artificial está teniendo en el día a día de las personas, grupos de pedófilos ya están creando y compartiendo en internet imágenes de explotación sexual de menores generadas con fotos de niños, niñas y adolescentes mayormente publicadas en redes sociales, propias o de sus madres y padres.

La mencionada entidad, tras sólo un mes de trabajo analizando un único sitio del “internet profundo” o “deep web”, detectó alrededor de 3 mil imágenes artificiales de niños actores y de niños sin una vida pública, sexualizados artificialmente. Esto se llama “deep fake”, para lo que se utiliza la Deep Face (“face”, rostro en inglés) y la Deep Voice (“voice”, voz en inglés), es decir, la modificación de la cara y voz de una persona en una foto o video simulando que es otra.

En diálogo con El Destape, Marina Benítez Demtschenko, abogada especialista en Derecho Informático, atajó las conclusiones más frecuentes ante esta información: “La crítica no debe estar enfocada solamente en el uso indebido de este tipo de sistemas, sino también en la responsabilidad de las empresas que permiten que sus desarrollos informáticos de inteligencia artificial se usen para esto”.

Según la experta, las empresas desarrolladoras tienen la posibilidad de inhibir usos de esta índole y no lo hacen porque “les genera lucro”, por lo que instó a las y los usuarios digitales a informarse sobre cómo funcionan las redes donde se exponen continuamente datos personales, en especial, a las y los adultos que publican fotos de menores de edad.

La solución a la circunstancia planteada es aún un debate abierto en el sistema judicial. Por su parte, Demtschenko coincide con otros expertos y expertas en que “hay una anomia”, es decir, faltan normas para resolver esta problemática en ascenso, pero “no desde lo legislativo”: “Lo que hay que resolver es la total disfuncionalidad de controles a tiempo. Esto es evitable. Los organismos internacionales tienen una red de detección preventiva de softwares que rastrean este tipo de contenidos, y tienen la capacidad de alertar a las fiscalías locales en Argentina si encuentran MASI”.

Por otro lado, la titular de la Unidad Fiscal Especializada en Delitos y Contravenciones Informáticas, Daniela Dupuy, opinó: “Si bien para muchísimas legislaciones penales esto ya es considerado un delito, la falta de un marco legal específico para castigarlo sigue siendo una deuda que tenemos en Argentina”.

Interpretación judicial

Tanto en Argentina como en otros puntos del mundo, existen casos de creación y distribución de MASI que ponen en jaque el enfoque judicial.

Por ejemplo, en la provincia de San Juan, el joven de 23 años Mario Leandro Pérez González fue denunciado por sus compañeras de la Facultad de Arquitectura y Diseño Gráfico de la Universidad Nacional de dicha provincia. Sin su consentimiento, había tomado fotos de las redes sociales de al menos 15 jóvenes, para luego “desnudarlas” borrando su ropa mediante el uso de inteligencia artificial y posteriormente venderlas con precio en dólares a un sitio web para adultos.

El caso fue tratado por la Justicia de Faltas de San Juan, y los fiscales descartaron la comisión de un delito tipificado en el Código Penal. Es que la edad de las víctimas es condicionante: cada vez más mujeres adultas también son agredidas sexualmente con la creación de “deep fakes” confundidas con pornografía lícita, pero “a nadie le importa”. En cambio, la creación, distribución e incluso la tenencia de “pornografía” con menores de edad no tiene discusión: es un delito sin grises legales o interpretativos.

Así, este caso fue tenido en cuenta por la Justicia después de que el Centro de Abordaje Integral de Niños, Niñas y Adolescentes Víctimas de esa provincia presentara un informe en el que alertaba que Pérez González tenía, además, material real de explotación sexual de chicas y chicos menores de 13 años que luego distribuía en redes como WhatsApp. Fue así que se concretó la condena a tres años de prisión condicional.

Tampoco existen los “grises” judiciales si las imágenes de niños, niñas y adolescentes son reales, ficticias o mixtas: “Las redes de detección primaria de los organismos internacionales registran si una persona tiene en su almacenamiento local o en la nube material de abuso sexual infantil, sin importar si es artificial o real”.

Es a raíz de esta lógica que la abogada consultada insiste en que no es necesario que haya exclusivamente un tipo penal a crearse en la normativa de fondo para los delitos ejecutados a través de la inteligencia artificial, ya que la comercialización o tenencia de MASI son acciones que habilitan procesos de investigación penal por sí mismos.

Chantaje: caso en España

“Mamá, están circulando fotos mías con el pecho desnudo”, contó una adolescente de 14 años en septiembre del corriente año, en Almendralejo, España. Su madre, María Blanco Rayo, contó a la BBC: “Le pregunté si se había tomado fotos desnuda y dijo: ‘No, mamá, son fotos falsas de niñas que están siendo creadas y hay otras chicas de mi clase a las que les ha pasado también’”.

Además de la hija de María, hubo 24 niñas y adolescentes de Almendralejo y cercanías, entre los 11 y los 17 años, que han denunciado lo mismo: sus fotos fueron tomadas de las redes sociales para luego ser “desnudadas” mediante una aplicación de IA.

A esta problemática se suma que los agresores extorsionaron a las familias exigiéndoles dinero a cambio de no difundir las imágenes de algunas de ellas.

Educación sexual integral: caso en Perú

En el colegio St George’s College, ubicado en el distrito peruano de Chorrillos, fueron entre 14 y 16 las adolescentes mujeres víctimas de la manipulación de fotografías y videos suyos sacados de sus redes sociales con fines de explotación sexual.

Los presuntos responsables serían sus propios compañeros varones, de entre 13 y 14 años que, mediante una aplicación, insertaron las caras de sus compañeras en cuerpos desnudos falsos para venderlos a otros alumnos del mismo centro educativo. Se investiga actualmente si adultos ayudaron a los adolescentes en la creación y distribución de las imágenes en cuestión.

El caso denota la poca complejidad en la producción de este tipo de material ilícito y el machismo que existe en las estadísticas de hombres productores de “pornografía” y de mujeres víctimas, que se aprehende desde cortas edades. Se pone en evidencia, nuevamente, la urgencia de la implementación de programas de educación sexual integral en todas las escuelas.

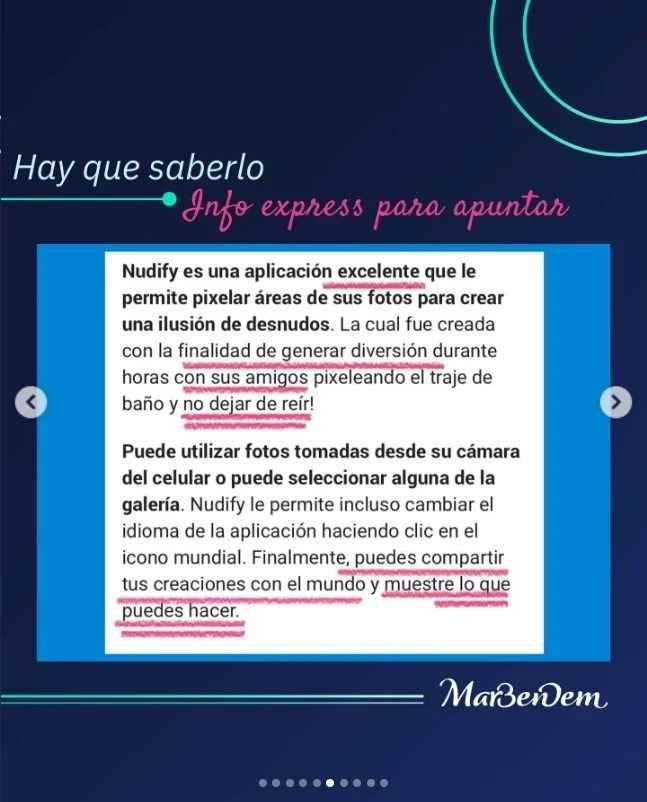

En este sentido, la abogada publicó en su cuenta de Instagram profesional @marbendem, donde difunde información relativa al derecho digital, el tono discursivo en el que algunos programas y apps de inteligencia artificial se promocionan: “Nudity es una aplicación excelente que le permite pixelar áreas de sus fotos para crear una ilusión de desnudos. La cual fue creada con la finalidad de generar diversión durante horas con sus amigos pixelando el traje de baño y no dejar de reír”.

“Finalmente, puedes compartir tus creaciones con el mundo y muestre lo que puedes hacer”, proponen los creadores de la app.

Aun así, Demtschenko busca no “demonizar” y responsabilizar a la herramienta tecnológica como tal. De lo contrario, se caen en enfoques incongruentes de la problemática: “Hoy se está discutiendo si la inteligencia artificial tendría que ser responsabilizada per sé por esto, o sea, dotarla de un carácter de persona o de entidad diferente a la humana, lo cual es una ridiculez”.

Por esto último, reflexionó: “Está bien que pensemos en que hay personas que hacen el mal, pero lo hacen con cualquier instrumento. Las redes de distribución y comercialización de material de abuso sexual infantil a nivel mundial son literalmente imparables y cada vez mayores. Es necesario estudiar y controlar esa actividad, no luchar contra un software”.

© Copyright 2020-Radio Bicentenario 98.3 . Design by: Futurisi